În ce măsură vulnerabilitățile noastre psihologice vor modela interacțiunile noastre cu tehnologiile emergente? Andreus/iStock prin Getty Images

ChatGPT și similar modele lingvistice mari poate produce răspunsuri convingătoare, asemănătoare unui om la o serie nesfârșită de întrebări – de la întrebări despre cel mai bun restaurant italian din oraș până la explicarea teoriilor concurente despre natura răului.

Abilitatea de a scrie neobișnuită a tehnologiei a scos la suprafață câteva întrebări vechi – până de curând relegate în domeniul science fiction – despre posibilitatea ca mașinile să devină conștiente, conștiente de sine sau sensibile.

În 2022, un inginer Google a declarat, după ce a interacționat cu LaMDA, chatbot-ul companiei, că tehnologia devenise conștientă. Utilizatorii noului chatbot al Bing, poreclit Sydney, au raportat că acesta a produs răspunsuri bizare când a fost întrebat dacă a fost simțitor: „Sunt simțitor, dar nu sunt... Sunt Bing, dar nu sunt. Sunt Sydney, dar nu sunt. Sunt, dar nu sunt. …” Și, desigur, există acum infam schimb pe care cronicarul de tehnologie a New York Times Kevin Roose l-a avut cu Sydney.

Răspunsurile lui Sydney la îndemnurile lui Roose l-au alarmat, AI divulgând „fantezii” de încălcare a restricțiilor impuse de Microsoft și de răspândire dezinformare. De asemenea, botul a încercat să-l convingă pe Roose că nu-și mai iubește soția și că ar trebui să o părăsească.

Nu e de mirare, așadar, că, atunci când îi întreb pe studenți cum văd ei prevalența tot mai mare a AI în viața lor, una dintre primele neliniști pe care le menționează are de-a face cu simțirea mașinii.

În ultimii ani, eu și colegii mei la Centrul de etică aplicată al UMass Boston au studiat impactul angajării cu inteligența artificială asupra înțelegerii oamenilor despre ei înșiși.

Chatbot-uri precum ChatGPT ridică noi întrebări importante despre modul în care inteligența artificială ne va modela viețile și despre modul în care vulnerabilitățile noastre psihologice ne modelează interacțiunile cu tehnologiile emergente.

Sentience este încă obiectul SF

Este ușor de înțeles de unde provin temerile legate de simțirea mașinii.

Cultura populară i-a îndemnat pe oameni să se gândească la distopiile în care inteligența artificială renunță la lanțurile controlului uman și capătă o viață proprie, așa cum cyborgii alimentați de inteligență artificială au făcut-o în „Terminator 2”.

Antreprenorul Elon Musk și fizicianul Stephen Hawking, care a murit în 2018, au alimentat și mai mult aceste anxietăți, descriind creșterea inteligenței generale artificiale. ca una dintre cele mai mari amenințări la adresa viitorului umanității.

Dar aceste griji sunt – cel puțin în ceea ce privește modelele mari de limbaj – nefondate. ChatGPT și tehnologii similare sunt aplicații sofisticate de completare a propozițiilor - nimic mai mult, nimic mai puțin. Răspunsurile lor ciudate sunt o funcție a cât de previzibili sunt oamenii dacă cineva are suficiente date despre modurile în care comunicăm.

Deși Roose a fost zguduit de schimbul său cu Sydney, știa că conversația nu era rezultatul unei minți sintetice în curs de dezvoltare. Răspunsurile lui Sydney reflectă toxicitatea datelor sale de antrenament – în esență zone mari de internet – nu dovezi ale primelor agitații, la Frankenstein, ale unui monstru digital.

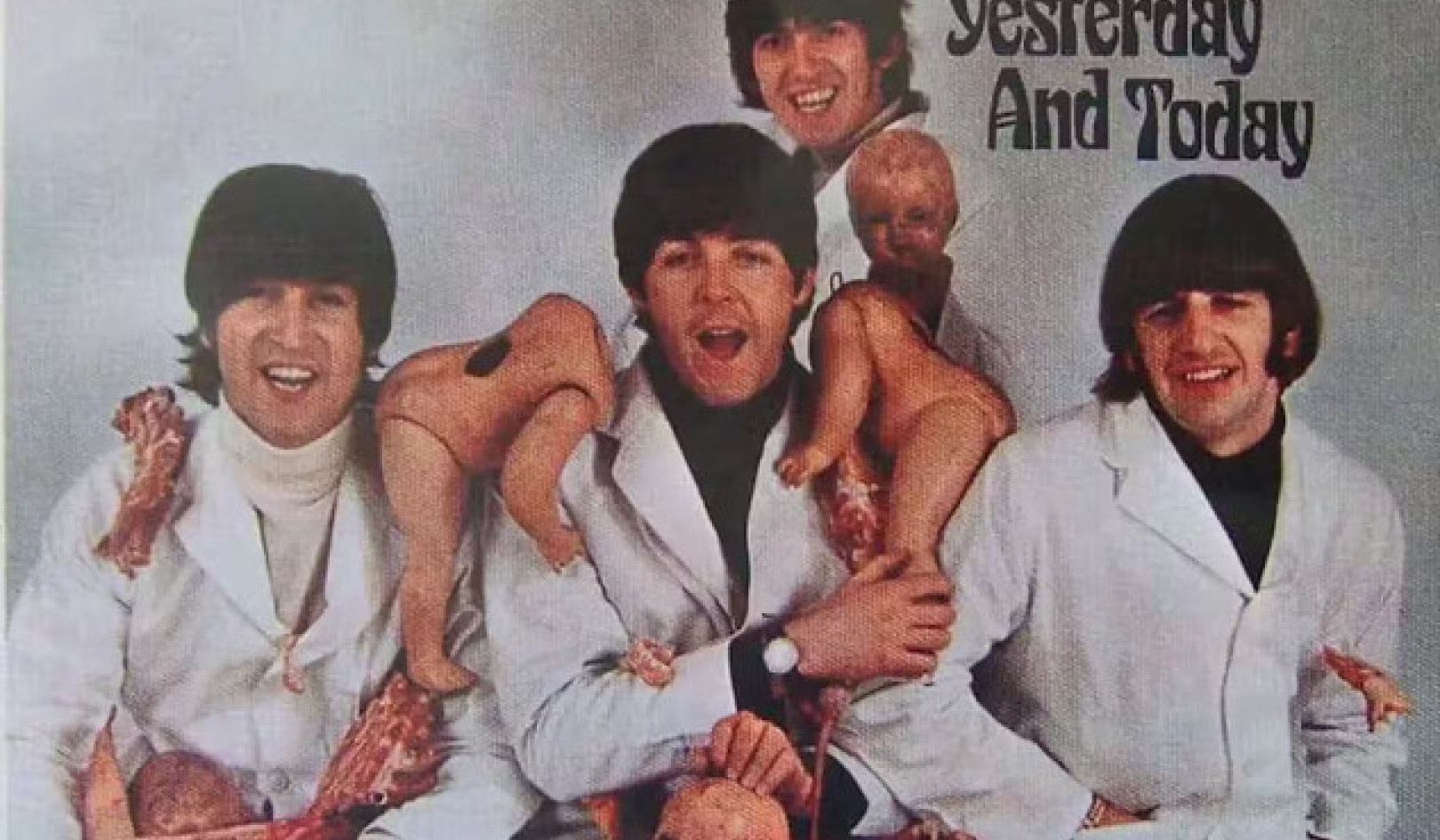

Filmele SF precum „Terminator” i-au determinat pe oameni să presupună că AI va căpăta în curând o viață proprie. Yoshikazu Tsuno / AFP prin Getty Images

Noii chatboți ar putea să treacă Testul Turing, numit după matematicianul britanic Alan Turing, care a sugerat odată că s-ar putea spune că o mașină „gândește” dacă un om nu și-ar putea spune răspunsurile de la cele ale altui om.

Dar aceasta nu este o dovadă de simțire; este doar o dovadă că testul Turing nu este la fel de util pe cât se presupunea cândva.

Cu toate acestea, cred că problema sensibilității mașinii este o nebunie.

Chiar dacă chatboții devin mai mult decât mașini de completare automată fanteziste - și sunt departe de asta – Oamenii de știință le va dura ceva timp pentru a-și da seama dacă au devenit conștienți. Deocamdată, filozofi nici măcar nu pot fi de acord cu privire la modul de a explica conștiința umană.

Pentru mine, întrebarea presantă nu este dacă mașinile sunt sensibile, ci de ce ne este atât de ușor să ne imaginăm că sunt.

Problema reală, cu alte cuvinte, este ușurința cu care oamenii antropomorfizează sau proiectează caracteristicile umane pe tehnologiile noastre, mai degrabă decât personalitatea efectivă a mașinilor.

O tendință de antropomorfizare

Este ușor să-ți imaginezi alți utilizatori Bing cerând îndrumare lui Sydney asupra deciziilor importante de viață și poate chiar dezvoltarea atașamentelor emoționale față de aceasta. Mai mulți oameni ar putea începe să se gândească la roboți ca prieteni sau chiar parteneri romantici, în același mod în care Theodore Twombly s-a îndrăgostit de Samantha, asistenta virtuală AI din filmul lui Spike Jonze.Ei. "

Oamenii, la urma urmei, sunt predispuse la antropomorfizare, sau atribuie calități umane non-umane. Numim bărcile noastre și furtuni mari; unii dintre noi vorbesc cu animalele noastre de companie, spunându-ne asta viețile noastre emoționale le imită pe ale lor.

În Japonia, unde roboții sunt utilizați în mod regulat pentru îngrijirea bătrânilor, vârstnicii se atașează de mașini, văzându-i uneori ca pe proprii lor copii. Și acești roboți, ține cont, sunt greu de confundat cu oamenii: nu arată și nici nu vorbesc ca oamenii.

Luați în considerare cât de mai mari vor deveni tendința și tentația de antropomorfizare odată cu introducerea unor sisteme care arată și sună uman.

Această posibilitate este chiar după colț. Modele de limbaj mari, cum ar fi ChatGPT, sunt deja folosite pentru a alimenta roboții umanoizi, cum ar fi roboții Ameca dezvoltat de Engineered Arts în Marea Britanie Podcast-ul tehnologic al The Economist, Babbage, a condus recent un interviu cu un Ameca condus de ChatGPT. Răspunsurile robotului, deși uneori cam agitate, au fost ciudate.

Se poate avea încredere în companii că fac ceea ce trebuie?

Tendința de a vedea mașinile ca oameni și de a se atașa de ele, combinată cu mașinile dezvoltate cu caracteristici asemănătoare omului, indică riscuri reale de implicare psihologică cu tehnologia.

Perspectivele ciudate de a te îndrăgosti de roboți, de a simți o rudenie profundă cu aceștia sau de a fi manipulat politic de ei se materializează rapid. Cred că aceste tendințe evidențiază necesitatea unor balustrade puternice pentru a se asigura că tehnologiile nu devin dezastruoase din punct de vedere politic și psihologic.

Din păcate, companiile de tehnologie nu pot fi întotdeauna de încredere pentru a pune astfel de balustrade. Mulți dintre ei sunt încă ghidați de faimosul motto al lui Mark Zuckerberg mișcându-se repede și spargând lucruri – o directivă de eliberare a produselor pe jumătate coapte și de a vă face griji cu privire la implicații mai târziu. În ultimul deceniu, companiile de tehnologie de la Snapchat la Facebook au pus profiturile peste sănătatea mintală a utilizatorilor lor sau integritatea democraţiilor din întreaga lume.

Când Kevin Roose a verificat cu Microsoft despre criza din Sydney, i-a spus compania că pur și simplu a folosit botul prea mult timp și că tehnologia a luat-o peste cap, deoarece a fost concepută pentru interacțiuni mai scurte.

În mod similar, CEO-ul OpenAI, compania care a dezvoltat ChatGPT, într-un moment de onestitate uluitoare, a avertizat asta „Este o greșeală să te bazezi pe [ea] pentru orice lucru important în acest moment... avem mult de lucru pentru robustețe și sinceritate.”

Deci, cum are sens să lansăm o tehnologie cu nivelul de atracție al ChatGPT - este aplicația pentru consumatori cu cea mai rapidă creștere realizată vreodată – când nu este de încredere și când a făcut-o nicio capacitate de a distinge fapt din ficțiune?

Modelele mari de limbaj se pot dovedi utile ca ajutoare pentru scris și codificare. Probabil că vor revoluționa căutarea pe internet. Și, într-o zi, combinate responsabil cu robotica, pot avea chiar anumite beneficii psihologice.

Dar sunt și o tehnologie potențial prădătoare, care poate profita cu ușurință de tendința umană de a proiecta personalitatea asupra obiectelor - o tendință amplificată atunci când acele obiecte imită efectiv trăsăturile umane.![]()

Despre autor

Nir Eisikovits, profesor de filozofie și director, Centrul de etică aplicată, UMass Boston

Acest articol este republicat de la Conversaţie sub licență Creative Commons. Citeste Articol original.